ÚLTIMAS

-

URGENTE: Criminoso é baleado em troca de tiros com o BPTAR

-

RECONHECIMENTO: Jornal Nacional destaca trabalho da Marquise ambiental no Ceará

-

DELEGADO CAMARGO: Projeto garante espaços acessíveis em locais públicos e privados

-

TEMPORÁRIO: Presidente da Câmara Municipal de Porto Velho esclarece suspensão de concurso

-

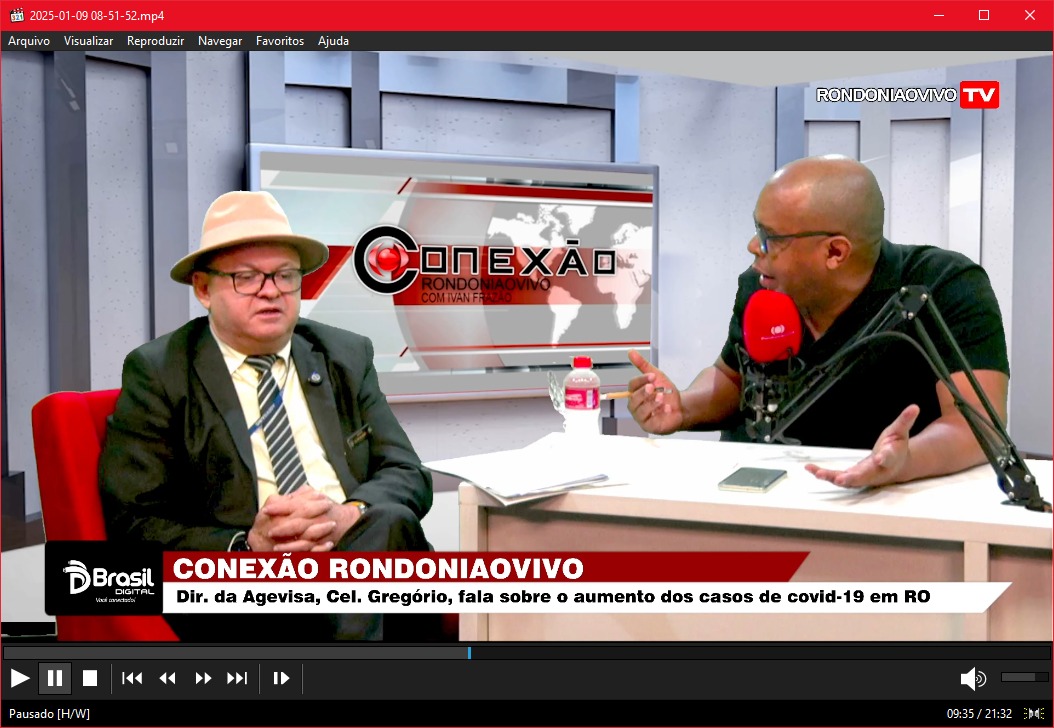

COVID-19: 'Maioria das mortes é de pessoas que não se vacinaram', diz Agevisa

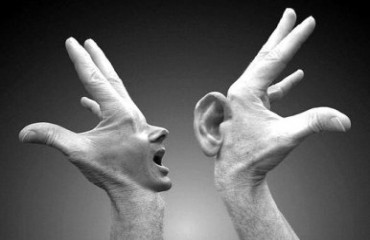

ARTIGO - A informação numa perspectiva não-antropomórfica – Por Vicente Marçal*

ARTIGO - A informação numa perspectiva não-antropomórfica – Por Vicente Marçal*

Foto: Divulgação

Receba todas as notícias gratuitamente no WhatsApp do Rondoniaovivo.com.

|

Contudo, tais usos manifestam uma compreensão antropomórfica do termo, entendido como mensagem lingüística, significativa e inédita (para o receptor), transmitida entre seres humanos. Esta compreensão antropomórfica do conceito de informação nos leva a três características primordiais, a saber: linguagem simbólica humana, significado e novidade (ou ineditismo).

No intuito de buscarmos uma compreensão não-antropomórfica da informação, afirmamos que a informação é genuinamente um elemento ontológico, juntamente com a energia e a matéria. Assim, segundo compreende-se a informação como propriedade fundamental do universo, buscamos fundamentação para essa tese em Aristóteles que propunha a ordem como parte integrante da realidade. A compreensão de Aristóteles, que implica dizer que a ordem é parte integrante da realidade, pode ser apreendida de seu escrito De Anima, onde explica a natureza da vida com base em sua doutrina metafísica da natureza geral das coisas.

Um segundo passo em direção a um conceito não-antropomórfico de informação é uma derivação do primeiro, i. e., a informação compreendia a partir de sua origem etimológica, como a medida de organização de um sistema. Nessa compreensão a informação se mantém, mesmo quando não utilizada por algum sistema diferente do sistema fonte de informação, como padrão organizacional dos sistemas.

Essa concepção de medida quantitativa nos leva para o terceiro passo em direção à desantropomorfização da noção de informação, a saber: a informação enquanto negaentropia.

Para compreendermos esse terceiro passo, temos que recorrer à Teoria Matemática da Comunicação de Shannon e Weaver. Estes apresentam a noção da informação enquanto a medida da liberdade de escolha entre as mensagens prováveis. Pois, ao se escolher uma mensagem, entre as prováveis, a mensagem escolhida transporta unidade de informação, as outras não.

Essa unidade de informação transportada por uma mensagem é uma decisão entre duas alternativas, por exemplo, animal e não-animal. Assim, com duas perguntas é possível decidir-se por uma em quatro possibilidades, do mesmo modo que com três é possível decidir-se por uma em oito possibilidades, o que nos leva à conclusão de que o logaritmo de base dois das possíveis decisões pode ser usado como medida da informação. Assim, se temos duas possibilidades de mensagem, a unidade de informação transportada é , caso tenhamos três possibilidades de mensagem, então a unidade de informação transportada será de , e assim sucessivamente.

Tal cálculo é semelhante ao da entropia, e Shannon e Weaver estão cientes disso. Contudo a entropia é o grau de desordem de um sistema, e se temos que, na Teoria Matemática da Comunicação, a medida da unidade de informação é correspondente à medida de entropia de um sistema, então temos uma contradição aqui, pois no segundo passo afirmamos que a informação é a medida de ordem de um sistema, e aqui estamos apontando para a informação como um correlato à medida de desordem de um sistema. Como resolver essa contradição?

Como proposta de solução dessa contradição devemos compreender que existem dois níveis de análise. O primeiro foca somente a fonte de informação, sendo que quanto mais organizada menor será sua medida de unidade de informação. O segundo propõe uma correlação entre o sistema fonte de informação e o sistema receptor da informação, ou seja, a correlação entre dois sistemas. Caso essa correlação seja inexistente, i. e., igual a zero, não haverá transmissão de informação; caso seja maior que zero, menor ou igual a um, ocorrerá a transmissão de informação. Solucionando, assim, a contradição que aparentemente se nos apresentava.

Devemos lembrar que a Segunda Leia da Termodinâmica nos ensina que todo sistema físico que for isolado de seu meio tende a ter sua entropia maximizada, ou seja, um sistema fechado terá uma redução de sua energia livre, i. e., a energia de um sistema que pode realizar algum trabalho no ambiente; e aumento de sua energia térmica incapaz de realizar trabalho, em outras palavras o sistema tende a afastar-se de uma situação mais organizada para uma situação desorganizada/caótica.

A informação é, desse modo, o motor que dá início ao processo de complexificação de um sistema, ou seja, é a informação que propicia a um sistema sua passagem de uma complexidade menor para uma complexidade maior, sem gerenciar tal processo.

O que nos leva a um novo impasse, pois buscamos argumentar sobre o fato da informação ser o motor que inicia o processo de ampliação da organização de um sistema e a Segunda Lei da Termodinâmica, mostra que a natureza de um sistema é tender justamente para a sua total desorganização. Como responder a esse impasse?

Devemos, então ressaltar que a Segunda Lei é referente a sistemas isolados, ou seja, sistemas fechados que não mantém nenhuma relação com o meio. Em sistemas abertos há uma relação com o meio. Essa relação propicia uma troca com o meio, essa troca favorece o equilíbrio do sistema impedindo, assim, o aumento de sua entropia. Em relação aos seres vivos, é o alimento ingerido que serve não apenas como fonte de energia, mas principalmente, como fonte de energia livre, compensando o aumento da entropia.

Podemos concluir que, seno a informação medida da negaentropia, o aumento da entropia destrói a informação e, consequentemente, o inverso também é verdadeiro, ou seja, que a informação reduz a entropia. Enquanto elemento redutor da entropia, a informação propicia não somente a manutenção do equilíbrio do sistema, mas também a possibilidade de aumentar sua complexidade organizada, ou seja, a informação não apenas supre os organismos vivos da energia utilizada nos processos vitais, mas aumenta a complexidade organizada que os caracteriza como sistemas vivos.

Logo, a informação fornecida pelo meio é processada pelo sistema que pode dar início ao processo de aumento da complexificação de um sistema. A informação é responsável pelo “start” do processo, contudo não é reguladora e nem supervisora do mesmo, pois o processo é de auto-organização, não possuindo um centro regulador.

*Vicente Eduardo Ribeiro Marçal

Professor Assistente I

Departamento de Filosofia

Fundação Universidade Federal de Rondônia

Editor Adjunto Revista Schème: www.marilia.unesp.br/scheme

Blog: www.espacointuitivo.blogspot.com

Siga-me: www.twitter.com/vicentemarcal

Professor Assistente I

Departamento de Filosofia

Fundação Universidade Federal de Rondônia

Editor Adjunto Revista Schème: www.marilia.unesp.br/scheme

Blog: www.espacointuitivo.blogspot.com

Siga-me: www.twitter.com/vicentemarcal

A política de comentários em notícias do site da Rondoniaovivo.com valoriza os assinantes do jornal, que podem fazer comentários sobre todos os temas em todos os links.

Caso você já seja nosso assinante Clique aqui para fazer o login, para que você possa comentar em qualquer conteúdo. Se ainda não é nosso assinante Clique aqui e faça sua assinatura agora!

Na sua opinião, qual companhia aérea que atende Rondônia presta o pior serviço?

Você ainda lê jornal impresso?

* O resultado da enquete não tem caráter científico, é apenas uma pesquisa de opinião pública!

MAIS NOTÍCIAS

Por Editoria

PRIMEIRA PÁGINA

CLASSIFICADOS veja mais

EMPREGOS

PUBLICAÇÕES LEGAIS

DESTAQUES EMPRESARIAIS

EVENTOS

© 2025, Rondoniaovivo.com. Todos os direitos reservados